|

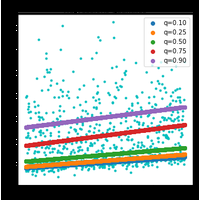

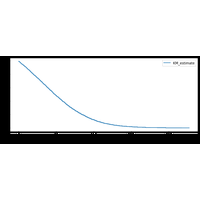

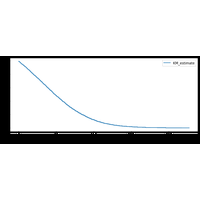

Analyse de survie |

|

|

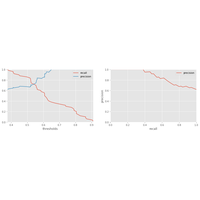

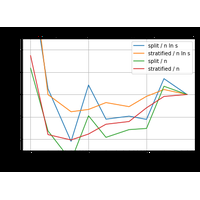

Benchmark |

Ce notebook compare différents modèles depuis un notebook. |

|

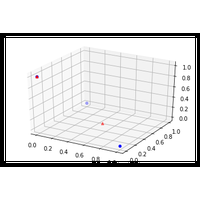

Factorisation et matrice et ACP |

Un exemple pour montrer l’équivalence entre l’ACP et une factorisation de matrice. |

|

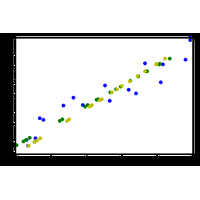

NeuralTreeNet et ONNX |

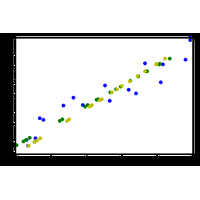

La conversion d’un arbre de décision au format ONNX peut créer des différences entre le modèle original et le modèle converti (voir Issues when switching to float. Le problème vient d’un changement de type, les seuils de décisions sont arrondis au float32 le plus proche de leur valeur en float64 (double). Qu’advient-il si l’arbre de décision est converti en réseau de neurones d’abord. |

|

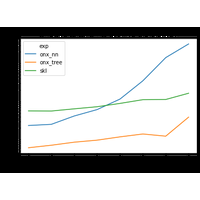

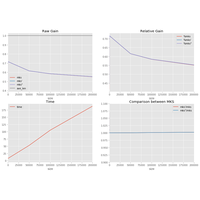

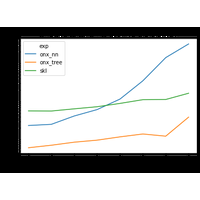

NeuralTreeNet et coût |

La classe NeuralTreeNet convertit un arbre de décision en réseau de neurones. Si la conversion n’est pas exacte mais elle permet d’obtenir un modèle différentiable et apprenable avec un algorithme d’optimisation à base de gradient. Ce notebook compare le temps d’éxécution entre un arbre et le réseau de neurones. |

|

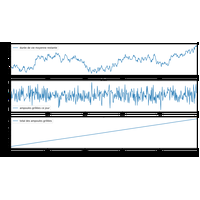

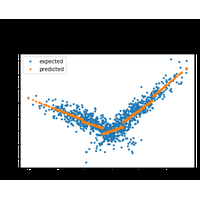

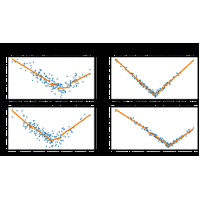

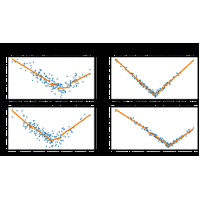

Régression linéaire par morceaux |

La régression linéaire par morceaux a l’avantage de produire un modèle localement interprétable. Mais ce n’est pas évident d’estimer un tel modèle quand on ne connaît pas les morceaux par avance. |

|

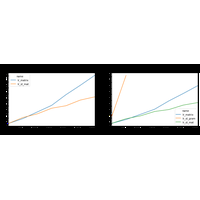

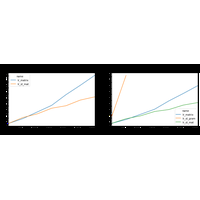

Régression sans inversion |

Ce notebook mesure le temps de calcul dans deux algorithmes pour résoudre une régression linéaire, le premier inverse un matrice, le second le fait sans inverser une matrice, le troisième reprend l’idée du second mais utilise une décomposition QR puis inverse la matrice R. |

|

Réseaux de neurones |

Réseaux de neurones avec scikit-learn. |

|

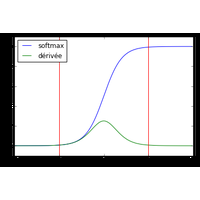

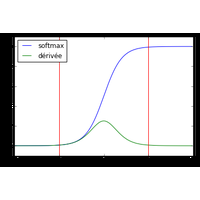

Un arbre de décision en réseaux de neurones |

L’idée est de convertir sous la forme d’un réseaux de neurones un arbre de décision puis de continuer l’apprentissage de façon à obtenir un assemblage de régression logistique plutôt que de décision binaire. |

|

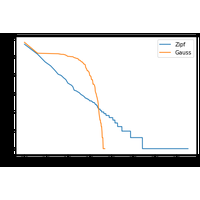

Valeurs manquantes et factorisation de matrices |

Réflexion autour des valeur manquantes et de la factorisation de matrice positive. |

|

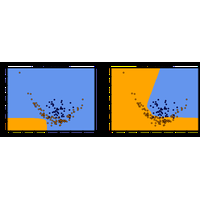

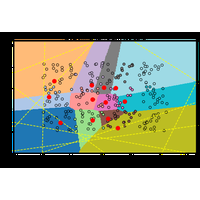

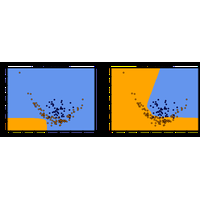

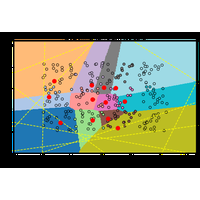

Voronoï et régression logistique |

Le notebook étudie la pertinence d’un modèle de régression logistique dans certaines configurations. Il regarde aussi le diagramme de Voronoï associé à une régression logistique à trois classes. Il donne quelques intuitions sur les modèles que la régression logistique peut résoudre. |